Llamafile: Giải pháp chạy mô hình ngôn ngữ lớn (LLM) đơn giản

Tương tự như GPT4All và Ollama , Llamafile đại diện cho một phương pháp tiếp cận mới trong việc phân phối và vận hành các mô hình ngôn ngữ lớn (LLM) thông qua các tệp thực thi tự chứa.

Công cụ này, được tạo ra bởi Mozilla, tạo điều kiện cho người dùng triển khAI các mô hình AI trực tiếp trên thiết bị của họ, loại bỏ nhu cầu cài đặt hoặc cấu hình phức tạp.

Với Llamafile, việc tiếp cận và sử dụng sức mạnh của các LLM trở nên dễ dàng hơn bao giờ hết, mở ra cơ hội cho nhiều đối tượng người dùng khám phá và ứng dụng trí tuệ nhân tạo.

Điểm mạnh của Llamafile nằm ở khả năng đóng gói toàn bộ mô hình và các phụ thuộc cần thiết vào một tệp duy nhất, giúp quá trình chia sẻ và triển khai trở nên nhanh chóng và thuận tiện.

Llamafile là gì?

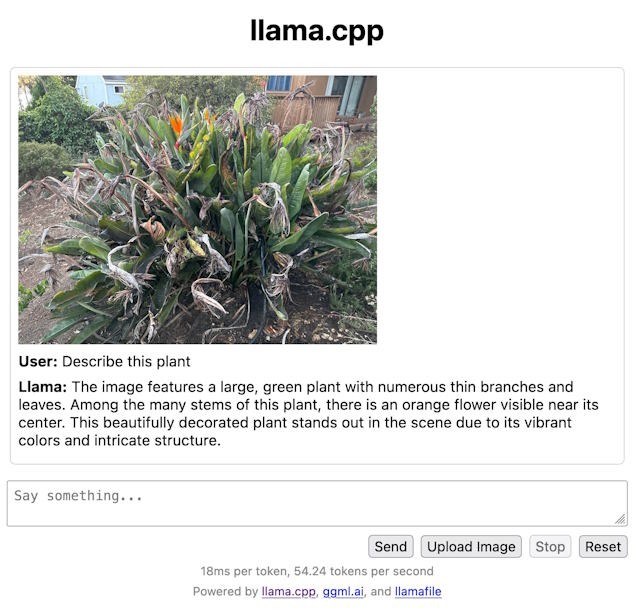

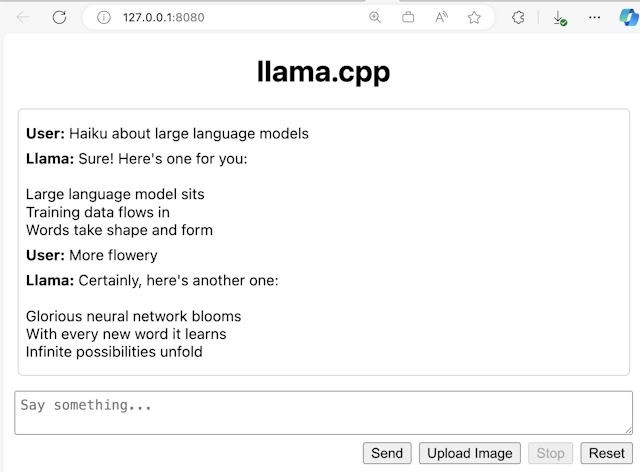

Llamafile, một sáng kiến từ Mozilla Builders, mang đến giải pháp phân phối và vận hành các mô hình ngôn ngữ lớn (LLM) thông qua một file duy nhất. Sự đổi mới này được xây dựng dựa trên sự kết hợp của llama.cpp – một framework chatbot LLM mã nguồn mở – và Cosmopolitan Libc, một thư viện C đa nền tảng. Điều này đảm bảo khả năng tương thích rộng rãi trên nhiều hệ điều hành khác nhau.

Nhờ sự tích hợp này, Llamafile tạo ra các ứng dụng AI độc lập, không đòi hỏi quá trình thiết lập môi trường phức tạp hay cài đặt thêm các phần mềm hỗ trợ.

Llamafile lưu trữ các tham số của mô hình trong một file ZIP không nén, cho phép truy cập trực tiếp vào GPU để tối ưu hóa hiệu suất. Khi được khởi chạy, hệ thống sẽ tự động nhận diện các đặc tính của CPU để điều chỉnh hiệu năng, đảm bảo hoạt động trơn tru trên cả bộ xử lý Intel và AMD.

Công cụ này còn có khả năng biên dịch các đoạn mã dành riêng cho GPU theo yêu cầu, giúp Llamafile hoạt động hiệu quả trên macOS, Windows, Linux và BSD, hỗ trợ cả kiến trúc AMD64 và ARM64.

Về mặt an ninh, Llamafile tận dụng các cơ chế pledge() và SECCOMP để giới hạn quyền truy cập vào hệ thống, qua đó bảo vệ an toàn cho người sử dụng.

Hơn nữa, Llamafile tương thích với API định dạng của OpenAI, tạo điều kiện thuận lợi cho các nhà phát triển trong việc tích hợp nó vào các dự án hiện có. Việc nhúng trực tiếp trọng số vào file thực thi hoặc tải riêng cũng rất linh hoạt, đặc biệt hữu ích trong các môi trường có dung lượng lưu trữ hạn chế như Windows.

Điểm nổi bật của Llamafile

Llamafile mang đến khả năng tương thích trên nhiều hệ điều hành khác nhau, bao gồm macOS, Windows, Linux, FreeBSD, OpenBSD và NetBSD. Đồng thời, công cụ này hỗ trợ đa dạng các kiến trúc CPU và tận dụng sức mạnh tăng tốc GPU.

Hiệu quả và Tốc độ Xử lý

Nhờ việc tích hợp tinyBLAS để tối ưu hóa GPU, cùng với các cải tiến về CPU, Llamafile giúp việc vận hành các mô hình AI trên thiết bị cá nhân diễn ra nhanh chóng và ổn định hơn.

Sự Đơn Giản Trong Sử Dụng

Việc chuyển đổi trọng số mô hình thành một tệp thực thi trở nên dễ dàng hơn bao giờ hết, chỉ với một lệnh duy nhất. Điều này giúp đơn giản hóa đáng kể quy trình triển khai.

Mã Nguồn Mở và Cộng Đồng

Llamafile được phát hành dưới giấy phép Apache 2.0, tạo điều kiện cho sự đóng góp và phát triển từ cộng đồng người dùng.

Khả Năng Mở Rộng và Tương Thích

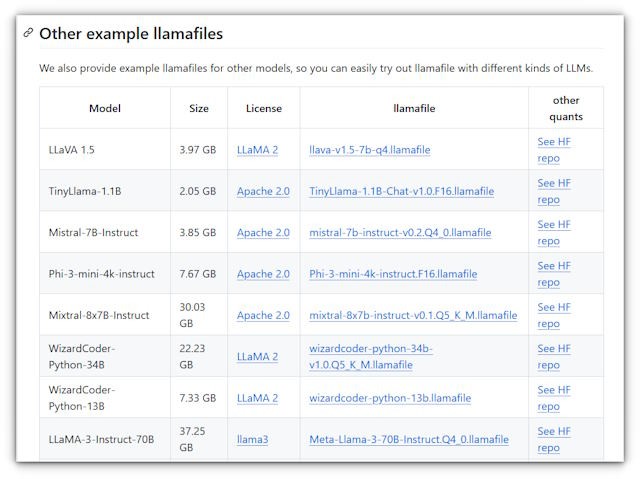

Công cụ này hỗ trợ việc sử dụng trọng số từ bên ngoài và tương thích với nhiều nền tảng AI phổ biến, trong đó có Hugging Face.

Tóm lại, Llamafile là một giải pháp mạnh mẽ và dễ tiếp cận để chạy các mô hình ngôn ngữ lớn (LLM) trực tiếp trên máy tính cá nhân, mà không đòi hỏi các thiết lập phức tạp. Với lợi thế về mã nguồn mở, khả năng tương thích rộng rãi và hiệu suất cao, Llamafile đang dần khẳng định vị thế của mình như một công cụ quan trọng đối với những ai muốn ứng dụng AI vào công việc và cuộc sống.

Xem thêm: Llamafile: Chạy LLM cục bộ với Mozilla .